Время на прочтение:3мин

В условиях стремительного развития технологий ИИ и увеличения тенденции их внедрения в различные сферы деятельности создают необходимость усиления контроля использования таких технологий.

Наряду с впечатляющими результатами, которые демонстрируют ИИ и потенциалом данных технологий, встают вопросы, связанные с недостаточной их изученностью, склонностью к галлюционированию и предвзятостью, что препятствует разработке безопасного и заслуживающего доверия искусственного интеллекта. В связи с этим, для целей нивелирования рисков использования ИИ мировое сообщество сосредоточено на формировании мер регулирования данного направления.

В марте 2024 г. Европарламентом принят Закон об искусственном интеллекте (AI Act). Закон об искусственном интеллекте – это первый нормативный акт такого уровня в области ИИ, устанавливающий общие рамки использования и распространения систем искусственного интеллекта в ЕС. Его целью является создание условий, способствующих разработке безопасного, заслуживающего доверия, надежного и этичного искусственного интеллекта в Европе и за ее пределами, посредством устранения рисков, связанных с очень мощными и действенными моделями ИИ.

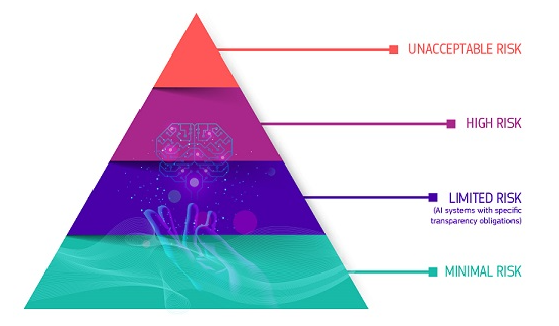

Законом предусматривается применение «риск-ориентированного подхода» регулирования ИИ, согласно которому системы с ИИ классифицируются по степени риска с установлением соответствующих требований и обязательств их использования.

Нормативный акт определяет 4 уровня риска для систем искусственного интеллекта:

Недопустимый риск (Unacceptable risk). Запрещены системы с ИИ, создающие угрозу общественной безопасности, использующие методы когнитивно-поведенческого воздействия на человека или социальный скоринг.

Высокий риск (High risk). К системам ИИ данной категории относят разработки, используемые в критически важной инфраструктуре, образовательной деятельности, трудоустройстве, предоставлении государственных услуг, в деятельности правоохранительных органов, которые могут нарушать основные права людей и др.

Все системы удаленной биометрической идентификации относятся Законом к высокорискованным, а использование удаленной биометрической идентификации в общедоступных местах для целей правоохранительных органов в принципе запрещено. Однако, строго определены и регулируются узкие исключения, например, поиск пропавшего ребенка, предотвращение террористической угрозы, судебное преследование виновного или подозреваемого в совершении тяжкого уголовного преступления. Такое использование разрешается, но должно быть санкционировано судебным или другим независимым органом и иметь соответствующие ограничения по времени, географическому охвату и поисковым базам данных.

Для разработчиков систем ИИ с высоким уровнем риска устанавливаются строгие требования, среди которых, внедрение системы оценки и управления рисками программного решения, использование наборов данных высокого качества, регистрация систем, ведение документации, содержащей всю необходимую информацию о системе, обеспечение высокого уровня надежности функционирования системы, безопасности и точности. Таким образом, данные требования позволяют охватить все аспекты жизненного цикла продукта.

Ограниченный риск (Limited risk). Законом определяются системы с ограниченным риском и вводятся обязательства по прозрачности систем с ИИ, связанные с необходимостью маркировки контента, созданного искусственно. Данные меры позволяют увеличить информированность пользователя об использовании технологий ИИ. Это также относится к аудио- и видеоконтенту, представляющему собой дипфейк.

Минимальный риск или его отсутствие (Minimal risk). Согласно положениям документа разрешается использование ИИ с минимальным риском. К данной категории относят такие приложения, как видеоигры с поддержкой ИИ или фильтры нежелательной почты. Подавляющее большинство систем ИИ, используемых в настоящее время в ЕС, подпадают под эту категорию.

Кроме того, законодателями установлены особые правила для ИИ общего назначения, вводящие обязательства по прозрачности для данных моделей и дополнительные обязательства по управлению рисками для очень эффективных моделей, включающих снижение системных рисков, необходимости отчетности о серьезных инцидентах, проведение оценки моделей и обеспечение безопасности их функционирования.

Таким образом, новый Закон устанавливает для разработчиков искусственного интеллекта правила, определяющие необходимость учета и предотвращения потенциального влияния, разрабатываемых систем, на широкий спектр факторов, таких как охрана здоровья и безопасности, защита персональных данных, конфиденциальность частной жизни, недопущение дискриминации и пр.

При этом, по мнению экспертов, для эффективной практической реализации положений Закона необходима разработка руководящих принципов по внедрению системы управления и оценки рисков, а также выполнению других требований закона в виде стандартов, учитывающих уникальные отраслевые особенности оценки качества, безопасности и надежности для систем искусственного интеллекта. Отмечается, что существующие стандарты, характерные для искусственного интеллекта, имеют среднюю или низкую «зрелость и уровень детализации», что может привести к непоследовательности в правоприменении, правовой неопределенности, препятствующей инновационному развитию. По сравнению с традиционным программным обеспечением проверка функций и компонентов систем искусственного интеллекта на более детальном уровне сопровождается сложностями ввиду технологической специфики таких разработок. В связи с этим, многие стандарты ИИ сосредоточены на процессах управления, прозрачности и контроле со стороны человека и остаются расплывчатыми в отношении технических спецификаций.

Системы ИИ общего назначения являются особенно сложной технологией с точки зрения стандартов безопасности и не всегда поддаются традиционным подходам к оценке рисков. Поскольку наборы данных, на которых они обучаются, огромны и разнообразны модели искусственного интеллекта могут выдавать разные выходные данные при схожих входных данных, а также обладают склонностью к “галлюцинации”, что ставит под сомнение их предсказуемость и надежность.

Таким образом, Закон ЕС об искусственном интеллекте знаменует собой важный шаг на пути к регулированию быстроразвивающейся области искусственного интеллекта, создавая прецедент для глобального регулирования цифровых технологий. Однако, существующая неопределенность в отношении допустимых пороговых значений риска и конкретных технических мер по снижению уровня его воздействия влечет за собой новые вопросы реализации положений Закона.